Die Finanzbuchhaltung ist ein wichtiges und komplexes Thema in Unternehmen, dem wir als Digitalisierungspartner häufig begegnen. Gerade wenn Unternehmen internationale Geschäftsbeziehungen unterhalten, fallen spezielle Vorgaben im Hinblick auf die Buchhaltung an. Stellen Sie sich diese Frage in einer Spielshow vor:

„Welches der folgenden Elemente kann nicht für Buchhaltungszwecke verwendet werden?“

- Eine Verkaufsrechnung

- Eine Proforma-Rechnung

- Eine Steuerrechnung

Die richtige Antwort ist „Proforma-Rechnung“. Hätten Sie Ihr ganzes Geld darauf gesetzt? Wenn ein Kunde eine Proforma-Rechnung verlangt, wissen Sie dann, wofür sie verwendet werden sollte und wofür nicht, und wie Sie eine Proforma-Rechnung versenden?

Was ist eine Proforma-Rechnung?

Eine Proforma-Rechnung ist eine vorläufige Rechnung oder eine geschätzte Faktura, die verwendet wird, um den verpflichteten Kaufenden zur Zahlung von Waren oder Dienstleistungen aufzufordern, bevor diese geliefert werden. Eine Proforma-Rechnung enthält eine Beschreibung der Waren, den zu zahlenden Gesamtbetrag und andere Einzelheiten über die Transaktion.

Wenn beispielsweise eine Vorauszahlung erforderlich ist, um die Finanzierung sicherzustellen, bevor Sie Waren herstellen oder eine Dienstleistung erbringen, kann eine Proforma-Rechnung verwendet werden, um die Einzelheiten der bevorstehenden Transaktion vorzuschlagen.

In vielerlei Hinsicht ist Proforma einem Angebot oder Kostenvoranschlag näher als einer Rechnung. Der Grund dafür ist, dass die Kundschaft nicht verpflichtet ist, den auf der Proforma aufgeführten Betrag zu zahlen, sodass der fällige Gesamtbetrag nicht in den Verbindlichkeiten der Kundschaft verbucht wird und dass Sie eine Proforma-Rechnung nicht zur Rückforderung der Mehrwertsteuer verwenden können.

Wann sollten Sie eine Proforma-Rechnung versenden?

Der wichtigste Punkt ist, dass eine Proforma-Rechnung in der Regel an einen Kunden oder Klienten geschickt wird, wenn er sich zum Kauf bei Ihnen verpflichtet hat, aber keine offizielle Rechnung erhalten kann, weil die endgültigen Details noch bestätigt werden müssen. Sobald der Kunde mit allem einverstanden ist, liefern Sie die Ware und stellen eine offizielle Rechnung aus.

Wie unterscheidet sich eine Proforma-Rechnung von anderen Rechnungsarten?

Um besser zu verstehen, wie sich eine Proforma in den Verkaufsprozess einfügt, werden im Folgenden die anderen gängigen Rechnungsarten erläutert:

Verkaufsrechnung

Eine Verkaufsrechnung ist eine förmliche Zahlungsaufforderung, die gleichzeitig mit oder kurz nach der Lieferung von Waren oder Dienstleistungen verschickt wird. Sie ist nicht nur eine Zahlungsaufforderung, sondern auch ein Steuerdokument, und wenn sie die Mehrwertsteuer enthält, kann sie auch als Steuerrechnung bezeichnet werden.

Handelsrechnung

Eine Handelsrechnung wird bei internationalen Sendungen verwendet, um dem Kunden und den Zollbeamten mitzuteilen, was versandt wird, wer der Verkäufer und Käufer ist, das Datum und die Verkaufsbedingungen, die Menge und das Gewicht der Waren und andere Einzelheiten. Handelsrechnungen werden verwendet, um den finanziellen Wert der gehandelten Waren und die eventuell anfallenden Steuern für die Sendung zu berechnen. Weitere Informationen finden Sie in unserem Leitfaden für Handelsrechnungen.

Gutschrift

Wenn Waren beschädigt sind oder ein Schreibfehler oder ein anderer Fehler vorliegt, enthält eine Gutschrift Einzelheiten über eine teilweise oder vollständige Erstattung der ursprünglichen Verkaufsrechnung oder eine Gutschrift, die für künftige Käufe verwendet werden kann.

Was sollte eine Proforma-Rechnung enthalten?

Der Hauptzweck einer Proforma-Rechnung besteht darin, Ihrem Kunden die Details der geplanten Transaktion zu zeigen. Sie sollte daher die gleichen Informationen enthalten wie die endgültige Rechnung:

Fazit: Mit der Proforma-Rechnung zu Unternehmenswachstum

Internationaler Handel muss nicht zwingend kompliziert sein. Wenn Sie wissen, wann Sie eine Proforma-Rechnung benötigen und welche Angaben diese enthalten muss, gelingt er Ihnen im Schlaf.

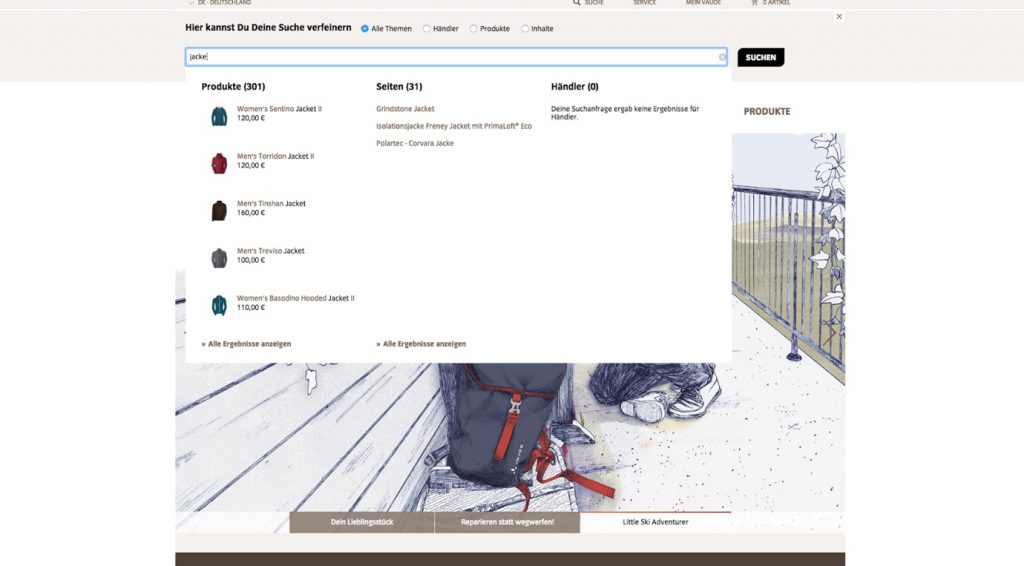

Unsere Empfehlung: Mit lexbizz können Sie schnell und unkompliziert die Proforma-Rechnung generieren und somit Zeit und Kosten sparen.